Будь-яка людина, тим більше той, який тільки починає свій шлях вебмастера, не може зробити ідеальний сайт для розкрутки в інтернеті і отримання прибутку з нього, якщо не знає призначення основних файлів движка, який він використовує. Однак існують однотипні файли, які використовують всі CMS — системи.

Один з таких файлів є robots.txt. Саме йому і присвячена дана стаття. Тут ми розглянемо правильне складання цього файлу і розповімо про деякі нюанси спрощення складання списку заборонених сторінок для власного сайту.

Що являють собою файли robots.txt

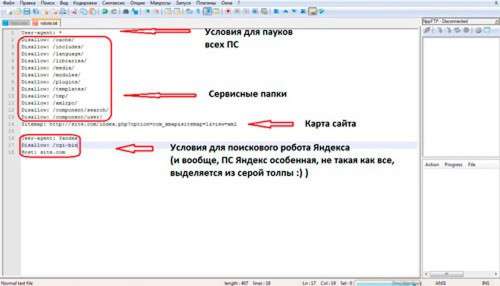

Robots.txt – текстовий файл, що відкривається звичайним блокнотом. Знаходиться він в кореневому каталозі будь-якого движка і складається зі списку заборонених для відображення в пошуковій видачі сторінок.

Кожен рядок цього файлу являє собою посилання на заборонену до індексації пошуковими системами сторінку. Іноді доводиться заборонити до показу кілька однотипних сторінок.

Припустимо, що у вас на сайті присутні теги, які створюються як окрема сторінка з видачею. Природно, пошуковим системам нема чого відображати цю інформацію, так як ви не тільки задублируете інформацію, але і створите зовсім непотрібну посилання в пошуковій видачі.

Для більш наочного розуміння варто навести приклад:

Site.com/tags/1

Site.com/tags/2

…

Таких тегів можуть бути тисячі, щоб не дублювати кожен тег новим рядком, можна ввести всього один рядок наступного виду:

Disallow: /tags/*

Це означає, що у вашому домені будуть заблоковані для видачі в пошуку сторінки, що мають у своєму адресу фразу «tags» на другому рівні (відразу після доменного імені).

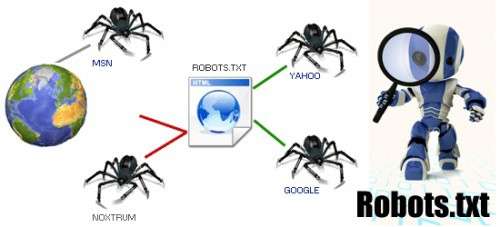

Навіщо взагалі потрібен файл robots.txt

Головна ідея цього файлу полягає в тому, щоб заборонити роботам пошукових систем відображати в пошуку сторінки, які будуть або дублювати інформацію, або відображати особисту інформацію користувачів сайту без попередньої реєстрації.

По-перше, це не дозволяє отримати користувачам інтернету особисту інформацію користувачів ресурсу, по-друге, в пошуку будуть відображатися тільки необхідні вам сторінки.

Це основні принципи, якими керуються творці сайтів, редагуючи текстовий файл robots. Правильно оформивши цей файл, ви дозволите пошуковим роботам індексувати тільки якісний контент зі свого сайту.

Як перевірити правильність файлу robots.txt

Перевірка на правильність оформлення файлу robots.txt для пошукових систем – одна з необхідних правил, якщо ви до цього жодного разу не користувалися движком, не знаєте всієї його структури або просто хочете зайвий раз перевірити свої знання, і переконатися в тому, що ваш robots.txt правильний.

Провести перевірку можна в спеціальних розділах для вебмайстрів в самих пошукових системах. В Google Webmaster подібний інструмент знаходиться у вкладці «Стан» —> «Заблоковані URL». У вікно вставити рядки вашого файлу robots.txt і в нижньому вікні введіть посилання на різні дані на вашому сайті для перевірки блокування.

Насправді дана перевірка не так проста, як вам здається, адже по суті доведеться перевірити елементи різних типів» сайту, наприклад: категорії, теги, сторінки, сторінки з параметрами і т. д. В результатах перевірки ви побачите, які сторінки дозволені для відображення в пошукових системах, а які заборонені.

В Яндекс Вебмастере все абсолютно аналогічно, за винятком того, що не можна вставляти рядки в полі, а вивантажити файл безпосередньо з сайту.

Як варіант, можна переглянути карту сайту і з карти сайту «повитягувати» кілька прикладів посилань для перевірки на блокування.

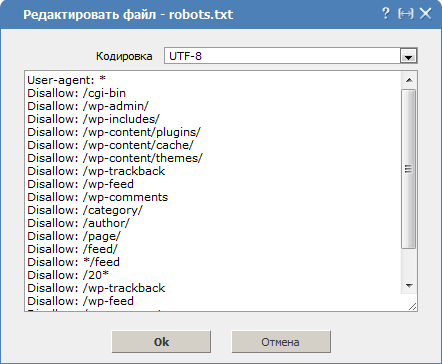

Приклад правильного файлу robots.txt для WordPress

Якщо у вас немає часу на складання власного файлу robots.txt для пошукачів, можете скористатися стандартним списком і за необхідності доповнити його.

Приклад правильного файлу robots для wordpress:

User-agent: *

Disallow: /cgi-bin

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

Disallow: /wp-trackback

Disallow: /wp-feed

Disallow: /wp-comments

Disallow: */trackback

Disallow: */feed

Disallow: */comments

Host: site.com

Також в кінці файлу не забудьте вказати посилання на карту сайту:

Sitemap: http://site.com/sitemap.xml

Також в кінці файлу не забудьте вказати посилання на карту сайту:

Sitemap: http://site.com/sitemap.xml

Зверніть увагу! Даний список є найоптимальнішим варіантом, але підходить тільки для типових сайтів без втручання в глобальний код системи/шаблону.

Як створити правильний robots.txt?

Враховуючи факт, що ідеальний варіант цього файлу потрібен кожному сайту, багато розробники модулів і плагінів вже подбали про його автоматичному створенні. Зараз ви можете без проблем знайти спеціальний генератор в інтернеті. Один з найбільш простих і зручних у використанні знаходиться тут.

Сервіси подібні до цього проводять ретельний аналіз вашої карти сайту і складають список дублів і непотрібних сторінок, роблячи ідеальний robots.txt для вашого сайту. Після генерації вам залишається лише скопіювати рядок у ваш файл, розташований на сервері і все.

Зверніть увагу! Файл Robots.txt не призначений для повного приховування сторінок від пошукових систем! Google, Yandex та інші пошукові системи просто не виносять заборонені сторінки в пошук і не додають їх у кількість проіндексованих, але все одно сканують їх.

Якщо, приміром, ви вирішите загнати у приховану від індексації сторінку якийсь вірус або шкідливий скрипт, пошукова система все одно визнає сайт шкідливим і можливо заблокує доступ до нього.

Хочемо звернути вашу увагу на те, що навіть найкращий генератор не здатний зробити список заблокованих сторінок ідеальним. Максимально правильно скласти список заблокованих посилань тільки власник сайту або досвідчений фахівець з SEO.

Тому, якщо в індексі пошукових систем з’явилися небажані сторінки вашого ресурсу або ви не знаєте, як правильно їх приховати, краще всього звернутися за допомогою до SEO-фахівцям або попросити допомоги на спеціалізованому форумі, надавши всю необхідну інформацію.

Наостанок хотілося б додати, що чинні в даний момент алгоритми Google перевіряють правильне створення файлу robots.txt це в свою чергу впливає на релевантність видачі сайту за запитами в пошуковій системі Google.

Якщо ви початківець веб-майстер, не варто поспішати з оформленням або тупим копіюванням рядків. Для початку вивчіть якомога більше інформації і тільки потім приступайте до складання файлу robots.txt.

Вдалого просування!